生成AIの導入は中小企業にとって大きなチャンスですが、何から始めれば良いか迷うことも。

本コラムは『中小企業のための「生成AI導入の進め方」実践シリーズ』の第4回です。

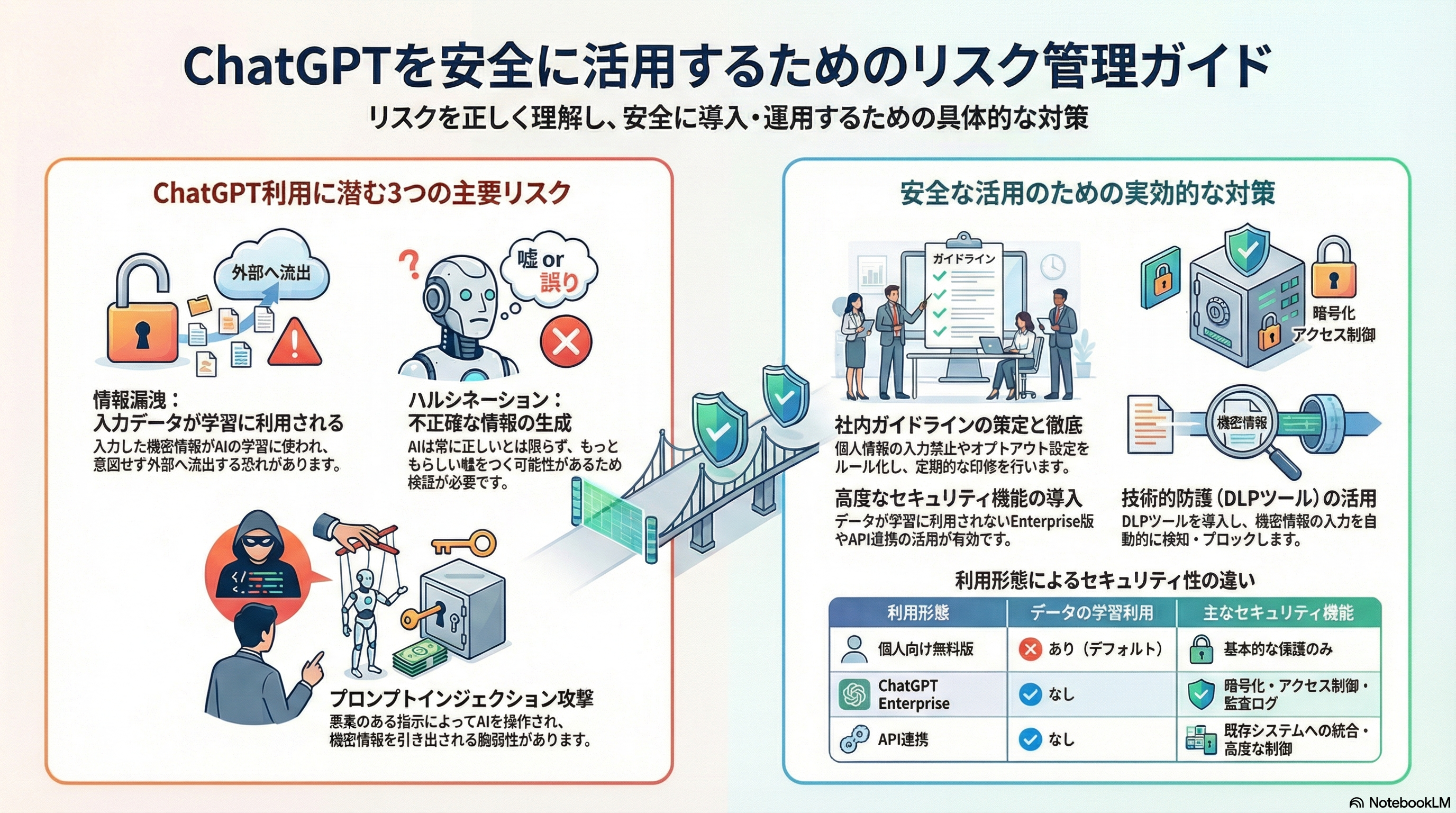

ChatGPTのような生成AIツールは業務効率化に貢献する一方で、情報漏洩や不適切な利用といったリスクも伴います。本記事では、ChatGPTを安全かつ効果的に業務で活用するための社内ガイドライン策定のポイントと、具体的な対策例を解説します。特に、企業が直面する可能性のあるリスクを理解し、従業員が安心して利用できる環境を整備するための情報を提供します。

目次

- ChatGPT利用におけるリスクと課題

- 社内ガイドライン策定のステップ

- 具体的な対策例:情報漏洩を防ぐために

- 法人向けChatGPT Enterpriseの活用

- まとめ:安全なChatGPT利用のために

絵で見る今回のコラム

ChatGPT利用におけるリスクと課題

情報漏洩リスク:学習データとしての利用

ChatGPTに入力された情報は、AIの学習データとして利用される可能性があります。

機密情報や個人情報が学習データに含まれることで、意図しない情報漏洩につながるリスクがあります。このリスクを最小限に抑えるためには、組織全体で情報管理に対する意識を高め、具体的な対策を講じることが重要です。

従業員一人ひとりが、どのような情報が機密に該当するのか、 また、それらの情報をどのように取り扱うべきかを理解する必要があります。入力する情報の種類や範囲について、明確なルールを定める必要があります。

たとえば、特定のプロジェクトに関する情報は、プロジェクトの関係者のみがアクセスできるように制限する、 あるいは、個人を特定できる情報は、 可能な限り匿名化してから入力するなどの対策が考えられます。

定期的な研修やワークショップを通じて、 従業員の情報セキュリティ意識を向上させることが不可欠です。

不正確な情報の生成:ハルシネーション

ChatGPTは大規模なテキストデータに基づいて学習していますが、 必ずしも正確な情報を生成するとは限りません。誤った情報や不適切な表現が含まれる可能性があり、 業務利用においては情報の信頼性を確認するプロセスが不可欠です。

特に、専門的な知識や最新の情報が必要な場合には、 ChatGPTの生成した情報を鵜呑みにせず、 必ず複数の情報源を参照し、内容を検証することが重要です。情報の信頼性を評価するためには、 その情報がどのような根拠に基づいているのか、 誰がその情報を提供しているのか

そして、その情報が他の情報源と一致しているかなどを確認する必要があります。 また、ChatGPTの生成する情報には、 バイアスが含まれている可能性もあるため、批判的な視点を持って情報を評価することが重要です。 必要に応じて、専門家によるレビューを受けることも有効です。

プロンプトインジェクション攻撃のリスク

悪意のあるプロンプト(指示文)を入力することで、 ChatGPTの動作を制御したり、機密情報を引き出したりする「プロンプトインジェクション」と呼ばれる攻撃手法が存在します。

これは、ChatGPTのような大規模言語モデルが、ユーザーからの入力をプログラムの命令として解釈してしまう脆弱性を利用したものです。 セキュリティ対策として、入力内容の検証やフィルタリングが重要です。

具体的には、不審な文字列やコードが含まれていないかチェックする、 特定のキーワードやパターンを検知したら警告を発するなどの対策が考えられます。また、ChatGPTのアクセス権限を制限し、 機密情報へのアクセスを必要最小限にすることも重要です。 定期的なセキュリティ診断を実施し、新たな脆弱性がないか確認することも不可欠です。

従業員に対して、プロンプトインジェクション攻撃の手法や対策について教育することも重要です。

社内ガイドライン策定のステップ

利用目的の明確化と範囲の限定

ChatGPTを業務で利用する目的を明確にし、利用範囲を限定します。 これにより、不必要な情報漏洩リスクを低減し、ChatGPTの利用をより効果的に管理することができます。

例えば、特定の部署や業務でのみ利用を許可する、機密情報を扱う業務での利用を禁止するなどのルールを設けます。 利用目的を明確化することで、 従業員はChatGPTをどのような場面で活用すべきか、また、どのような情報を入力すべきでないかを判断しやすくなります。

利用範囲を限定することで、 情報漏洩が発生した場合の影響範囲を最小限に抑えることができます。ガイドライン策定時には、 各部署の代表者や情報セキュリティ担当者などを交えて、 十分な議論を行うことが重要です。 また、策定したガイドラインは、定期的に見直し、改善していく必要があります。

情報セキュリティポリシーの強化

既存の情報セキュリティポリシーを見直し、 ChatGPTの利用に関する項目を追加します。情報漏洩対策、アクセス制限、データ管理など、具体的な対策を盛り込みます。

情報セキュリティポリシーは、組織の情報資産を保護するための基本的な方針を示すものです。ChatGPTの利用に関する項目を追加することで、 従業員はChatGPTの利用に関するルールや責任を明確に理解することができます。

情報漏洩対策としては、ChatGPTへの入力情報の制限、 オプトアウト設定の推奨、 DLPツールの導入などが考えられます。

アクセス制限としては、ChatGPTへのアクセス権限を必要最小限にすること、 多要素認証の導入などが考えられます。

データ管理としては、 ChatGPTの利用ログの記録、データの暗号化などが考えられます。 情報セキュリティポリシーの強化は、 組織全体の情報セキュリティレベルを向上させるために不可欠です。

従業員向け研修の実施

ChatGPTの利用に関する研修を実施し、 従業員のリスク認識を高めます。 情報セキュリティ、プロンプトの適切な作成方法、不適切な利用事例などについて教育します。

研修を通じて、従業員はChatGPTの利用に伴うリスクを理解し、 適切な行動をとることができるようになります。情報セキュリティに関する研修では、 情報漏洩のリスク、 プロンプトインジェクション攻撃の手法、 安全なパスワードの設定方法などを学ぶことができます。

プロンプトの適切な作成方法に関する研修では、 ChatGPTに意図した回答を得るためのプロンプトの書き方、 不適切なプロンプトの例などを学ぶことができます。不適切な利用事例に関する研修では、 ChatGPTを不適切に利用した場合のリスク、 具体的な事例などを学ぶことができます。

研修は、座学だけでなく、演習やグループワークなどを取り入れることで、 より効果的なものにすることができます。

具体的な対策例:情報漏洩を防ぐために

入力情報の制限:個人情報・機密情報の禁止

ChatGPTへの入力情報について、個人情報(氏名、住所、電話番号など)や企業の機密情報(財務情報、顧客情報、技術情報など)の入力を禁止します。 入力が必要な場合は、事前に上長への承認を得るなどのルールを設けます。

個人情報の入力禁止は、 個人情報保護法などの法令を遵守するために不可欠です。 企業の機密情報の入力禁止は、 企業の競争力を維持するために不可欠です。入力が必要な場合は、 上長の承認を得ることで、 情報漏洩のリスクを最小限に抑えることができます。

また、入力する情報を匿名化する、あるいは、仮名化するなどの対策も有効です。 従業員に対して、 どのような情報が個人情報や機密情報に該当するのかを明確に伝えることが重要です。定期的な研修やワークショップを通じて、 従業員の情報セキュリティ意識を向上させることが不可欠です。

オプトアウト設定の推奨

ChatGPTのオプトアウト設定(学習データの利用拒否)を推奨します。 これにより、入力された情報がAIの学習に利用されることを防ぎ、情報漏洩のリスクを低減できます。オプトアウト設定は、 ChatGPTの利用規約に基づいて行うことができます。

オプトアウト設定を行うことで、入力された情報がChatGPTの学習データとして利用されることを防ぎ、 情報漏洩のリスクを低減することができます。

ただし、オプトアウト設定を行うと、ChatGPTの回答の精度が低下する可能性があることに注意が必要です。 従業員に対して、 オプトアウト設定の方法を周知することが重要です。

また、オプトアウト設定を行うことのメリットとデメリットを説明することも重要です。 組織全体で、 オプトアウト設定を行うかどうかを検討し、統一的なルールを定めることが望ましいです。

DLP(Data LossPrevention)ツールの導入

DLPツールを導入することで、ChatGPTへの機密情報の入力を検知し、ブロックすることができます。 DLPツールは、 機密情報が組織外に漏洩するのを防ぐためのツールです。

DLPツールを導入することで、ChatGPTへの機密情報の入力を検知し、ブロックすることができます。 また、DLPツールの導入だけでなく、 運用体制を整備することも重要です。 DLPツールの導入と運用により、ChatGPTを利用する際の情報漏洩リスクを大幅に低減することができます。

法人向けChatGPT Enterpriseの活用

Enterprise版のメリット

法人向けChatGPTEnterpriseは、セキュリティ機能が強化されており、情報漏洩リスクを低減できます。 データの暗号化、アクセス制御、監査ログなどの機能が提供されます。 Enterprise版は、個々のニーズに合わせてカスタマイズできるため、 より柔軟な運用が可能です。

データの暗号化により、 万が一データが漏洩した場合でも、内容を解読されるリスクを低減できます。 アクセス制御により、 特定の従業員のみがChatGPTにアクセスできるように制限することができます。 監査ログにより、ChatGPTの利用状況を追跡し、 不正な利用を検知することができます。 Enterprise版の導入は、情報セキュリティ対策を強化する上で非常に有効な手段です。 導入を検討する際には、 自社のニーズを明確にし、 最適なプランを選択することが重要です。

API連携による利用

API連携を通じてChatGPTを利用することで、 入力データが学習に利用されるのを防ぐことができます。また、自社のシステムに組み込むことで、セキュリティレベルを維持したままChatGPTの機能を活用できます。

API連携は、 ChatGPTの機能をより安全に、 そして効率的に利用するための方法です。API連携を行うことで、 入力データがChatGPTの学習データとして利用されることを防ぎ、 情報漏洩のリスクを低減することができます。

また、自社のシステムにChatGPTを組み込むことで、 セキュリティレベルを維持したまま、 ChatGPTの高度な自然言語処理能力を活用することができます。API連携を行うためには、 専門的な知識が必要となる場合があります。 必要に応じて、 外部の専門家の支援を受けることも検討しましょう。

まとめ:安全なChatGPT利用のために

社内ガイドラインの策定と従業員への周知、そして適切なセキュリティ対策の実施により、ChatGPTを安全かつ効果的に業務で活用することができます。リスクを理解し、適切な対策を講じることで、ChatGPTのメリットを最大限に引き出すことが可能です。

ChatGPTは、業務効率化や創造性の向上に大きく貢献する可能性を秘めています。しかし、その一方で、情報漏洩や不正確な情報の生成といったリスクも存在します。これらのリスクを理解し、適切な対策を講じることで、ChatGPTを安全かつ効果的に業務で活用することができます。

社内ガイドラインの策定は、ChatGPTの利用に関するルールを明確にする上で不可欠です。従業員への周知は、ガイドラインの内容を理解させ、遵守を促す上で重要です。適切なセキュリティ対策の実施は、情報漏洩のリスクを低減する上で不可欠です。ChatGPTのメリットを最大限に引き出し、リスクを最小限に抑えるために、これらの対策を総合的に実施することが重要です。

弊社では、「トラブル対応が属人化している」「情シスの負荷を減らしたい」「情シス業務・ヘルプデスクのアウトソーシング」といった中小企業のIT運用を支えるサービスをワンストップで提供しています。

貴社のニーズに合わせて業務効率化や顧客対応自動化のご提案をさせていただきます。

お問い合わせはこちら